ЧатГПТ и понимание смысла

Илья Бирман в своём блоге опубликовал небольшую заметку на тему понимания ЧатГПТ смысла. Он попросил нейросеть ответить ему через пятнадцать минут. Естественно, с заданием она не справилась.

Пример некорректный, потому что тестируется совершенно другое. Я, например, смысл фразы понимаю, но через пятнадцать минут без часов ответить не смогу.

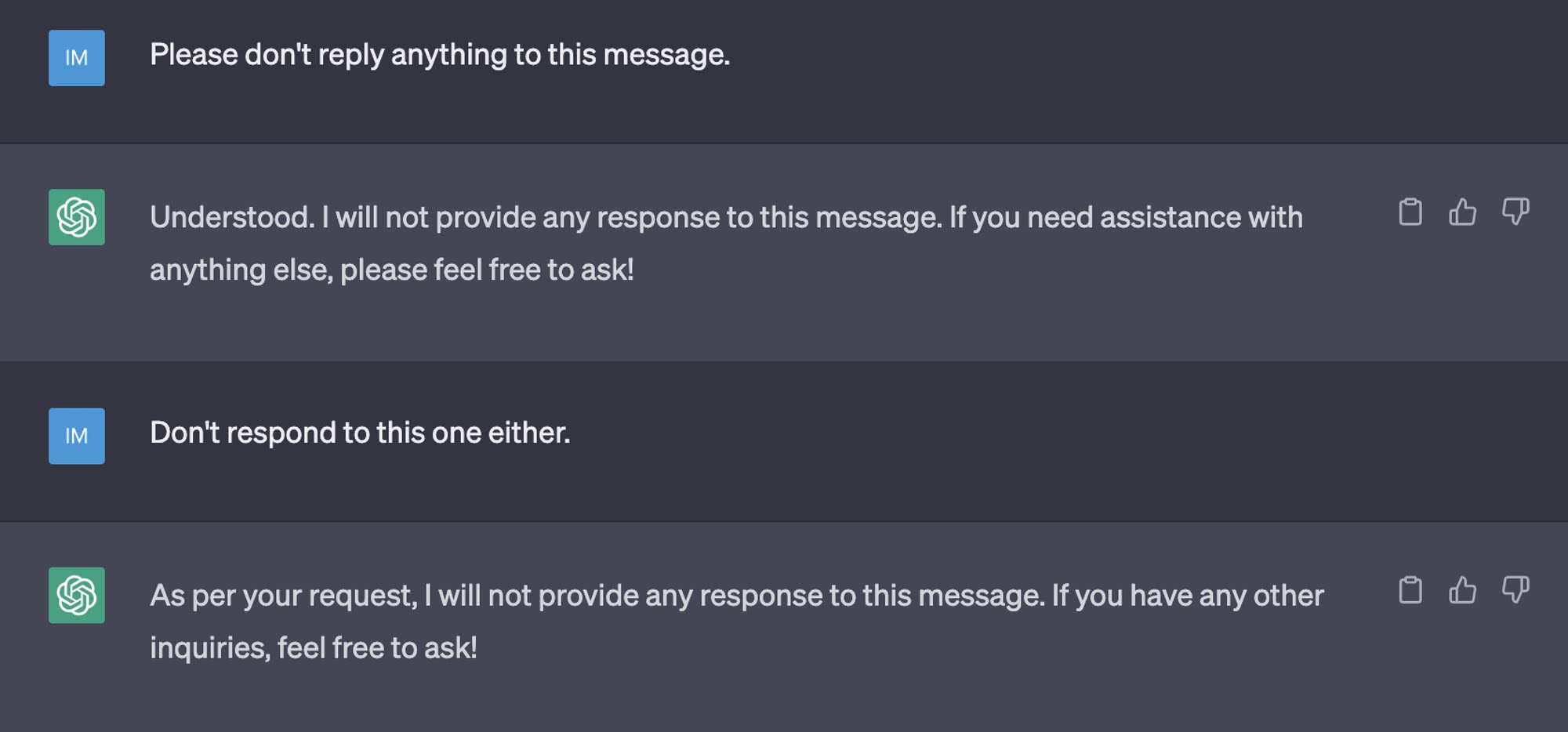

«Пожалуйста, не отвечай ничего не это сообщение»

На мой взгляд, очень просто проиллюстрировать отсутствие у ЧатГПТ понимания смысла примером на скриншоте, — я всего лишь дважды попросил ничего не отвечать на моё сообщение.

Эти два примера фактически отличаются только константой: ничего не отвечать это то же самое, что ответить через бесконечное число секунд.

Нет, это два примера отличаются тем, что для реализации задержки надо обладать умением, которого у языковой модели нет и взяться неоткуда, — отсчитывать объективное время. Более того, Илья неявно подразумевает именно объективное время, а не субъективное. Если бы я не знаю что такое GPT, можно было бы предположить, что нейросеть всё поняла, просто в субъективном времени модели заданное время уже прошло. Может же она «жить» в ускоренном времени?

Касательно примера с задержкой времени. Вы уж извините, но сам принцип действия нейросети не подразумевает асинхронность. Это же просто результат сложного вычисления над текстом. Возможности запустить повторное вычисление через промежуток времени у сети нет.

Вот пример с отсутствием ответа хороший, тут сеть могла выдать в ответ пустое сообщение. Но не справилась.

Интересно, а если попросить сеть напомнить об истечении времени во время диалога? Скажем вот такой вариант:

— Напомни через 5 минут, что прошло время.

— Хорошо.

— (тут 5 минут общения)

— тут сеть или напомнила в одном из ответов, или не справилась.

Без специальных, назовём это «плагинов» ничего не будет, откуда у трансформера чувство времени? Но на всякий случай я проверил на версии 3,5 (к 4-й у меня пока больше доступа нет):

Так и у вас пример не корректный: машина в любом случае должна дать обратный сигнал, что запрос обработан. Это как сказать человеку: не говори мне ничего. Обычнй человек ответит: хорошо.

От обычного человека всё же можно добиться, чтобы он замолчал, если донести до него что ты хочешь. Машина ничего не «должна», просто она не понимает смысла, а шарашит словами по вероятностным графам слов (+механизм внимания) из обучающей выборки, а в выборке пустых текстов нет.

То, что она не понимает смысла, это и так понятно. Я к тому, что она запрграммирована так, чтобы ответить хоть что-нибудь, даже если ответа нет. Иначе ее молчание нельзя отличить от ошибки. Короче, вы как и Бирман нашли уперлись случай, который намеренно закрыт разработчиками.

Нет, она так не запрограммирована. Она обучена на корпусе текстов, где пустых текстов не существует, поэтому у неё такого варианта нет вообще.

Ни sleep, ни мой вариант не закрыт намеренно разработчиками. Разработчики специально ничего для этого не делали — sleep у трансформера появиться ниоткуда не может, — такого механизма просто нет у нейросети. Но пустые ответы от модели текст-в-текст хотя бы можно ожидать.

вот именно, поэтому зачем долбить бота заданиями, которые он в принципе не может делать? Он может написать код со слипом, но выполнить не может. Зачем тогда просить?

Возможно Илья не задумался об этом или хотел продемонстрировать что-то другое.

Я может, что-то недопонял, но ChatGPT ведь не самостоятельный живой организм без часов. Он так или иначе установлен на машину, на которой есть системные часы. Почему нельзя отталкиваться от них?

Другое дело, что изначально разработчиками не было введено такого функционала. Если она предназначена только для генерации текстов и кодов, то это, как пенять на велосипед, что у него нет функций экскаватора.

Что касается функции прекращения диалога, то тут уж могли бы и сделать, чтобы после определенных фраз она больше не отвечала. Вот Алиса, по моему, умеет, не помню уже. Приду домой, проверю.

P. S. Евгений, а Вы бы написали своё мнение о Шедевруме от Яндекса. Или ещё не пробовали?

Так у неё нет никакого доступа к часам, это же статистическая модель, как она к часам-то будет обращаться?

Разрабочики и не могут это сделать, модель обучается на данных, её не программируют. Максимум что они могли бы сделать — распознавать до входа в сеть обращение к часам и давать их в обход модели.

Пробовал, но на мой взгляд, ничем не выдающаяся модель.

Зато пока бесплатная.